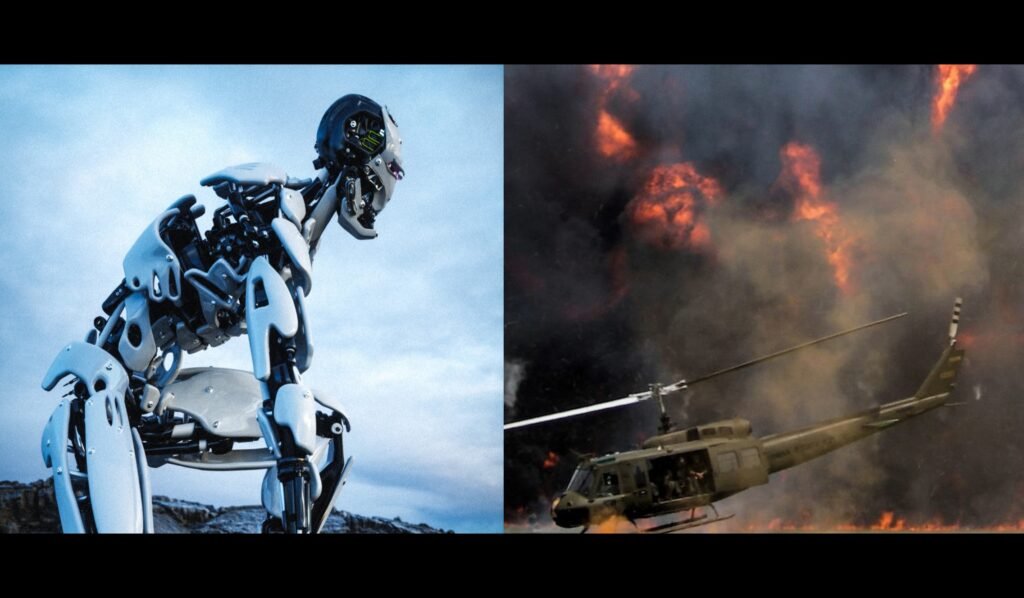

Sztuczna inteligencja zapoczątkowała nową erę wyścigu zbrojeń

Z miesiąca na miesiąc sztuczna inteligencja (AI ang. artificial intelligence) wdziera się w nasze codzienne życie coraz intensywniej, dlatego wielu ekspertów zadaje sobie pytanie dotyczące AI w kontekście światowego wyścigu zbrojeń, który już ma miejsce.

Reklama

Nowa era wyścigu zbrojeń

Sztuczna inteligencja zapoczątkowała wyścig zbrojeń, który może odmienić współczesne działania wojenne. Kraje, takie jak Stany Zjednoczone, Chiny, a nawet Rosja rywalizują o rozwój najnowocześniejszych technologii w rekordowym tempie, wywołując obawy, czy nadążymy nad ich możliwościami, zanim zostaną na dobre wdrożone.

„Jednym z wyzwań, które widzimy, jest to, jak zrozumieć, jakie są właściwe zastosowania tej technologii i jakie są potencjalne wady, przed którymi musimy być w stanie się obronić” — powiedziała Kathleen Fisher, dyrektor ds. w Agencji Zaawansowanych Projektów Badawczych Obrony Stanów Zjednoczonych (DARPA).

Jak ustrzec się przed zagrożeniami

Chociaż zrozumienie zagrożeń związanych z bronią napędzaną sztuczną inteligencją i zbudowanie odpowiednich barier ochronnych jest ważne, jeszcze większe niebezpieczeństwo pozostaje na horyzoncie, mówi Trae Stephens, dyrektor funduszu założycieli Petera Thiela i współzałożyciel start-upu obronnego Anduril Industries .

„Powinniśmy być zaniepokojeni autorytarnym systemem, który decyduje o tym, jakie będą te międzynarodowe regulacje. To jest ryzyko, które podejmujemy w bierności” – powiedział Stephens.

„Jeśli nie pochylimy się do przodu, aby zdefiniować te rzeczy jako społeczeństwo, stracimy naszą pozycję lidera, aby zająć miejsce przy tym stole” – dodał.

Reklama

Czy rozwój AI jest obecnie kontrolowany?

Przypomnijmy, że to urzędnicy unijni, jako pierwsi na świeci podjęli próbę usankcjonowania przepisów dotyczących korzystania ze sztucznej inteligencji. Już w 2021 roku Komisja Europejska przedstawiła projekt przepisów wychodząc na przeciw zagrożeniom wynikającym z powstającej technologii, która przeżyła gwałtowny wzrost popularności po wypuszczeniu ChatGPT. Zgodnie z projektem, poszczególne narzędzia sztucznej inteligencji będą klasyfikowane zgodnie z postrzeganym poziomem ryzyka: od minimalnego do ograniczonego, wysokiego i niedopuszczalnego. Chociaż narzędzia wysokiego ryzyka nie zostaną zakazane, to osoby, które ich używają, będą podlegały kontroli.

List otwarty dot. dalszego rozwoju sztucznej inteligencji

Kilka tygodni temu grupa ekspertów od sztucznej inteligencji, w tym dyrektorzy branży oraz Elon Musk wezwali do sześciomiesięcznej przerwy w systemach szkoleniowych potężniejszych niż nowo wprowadzony model OpenAI GPT-4, powołując się na potencjalne ryzyko dla społeczeństwa i ludzkości. List wydany przez organizację non-profit Future of Life Institute (pol. Instytut Przyszłości Życia) podpisany został przez ponad 1000 osób, w tym m.in. Elona Muska, AI Emada Mostaque – założyciela i dyrektora generalnego Stability AI, jednej z firm stojących za Stable Diffusion, a także naukowców z należącego do Alphabet DeepMind, Yoshua Bengio – kanadyjskiego informatyka, znanego ze swoich prac nad sztucznymi sieciami neuronowymi oraz głębokim uczeniem maszynowym oraz Stuarta Russella – brytyjskiego eksperta w dziedzinie sztucznej inteligencji.

Reklama

Naukowcy wezwali do wstrzymania rozwoju zaawansowanej sztucznej inteligencji do czasu opracowania, wdrożenia i audytu przez niezależnych ekspertów wspólnych protokołów bezpieczeństwa dla takich projektów.

„Potężne systemy sztucznej inteligencji powinny być opracowywane tylko wtedy, gdy mamy pewność, że ich efekty będą pozytywne, a ryzyko będzie możliwe do opanowania” – napisano w liście.

źródło: Bloomberg, tematem.pl

autor: KZ | 05.05.2023, 11:30

tagi: Aktualności, Technologie

Przeczytaj jeszcze:

Porozumienie prawodawców unijnych w sprawie AI

Sztuczna inteligencja najszybciej wyprze z tych zawodów

IBM zastąpi 7800 miejsc pracy sztuczną inteligencją

Niemieckie związki zawodowe autorów vs ChatGPT

Naukowcy wezwali do wstrzymania się od szkolenia systemów AI